Cómo usar IA localmente con Ollama

Descubre cómo ejecutar IA localmente con Ollama para mayor seguridad y control de datos. Aprende a crear tu propia base de conocimiento, integrar modelos como Mistral y LLaMA, y automatizar procesos con herramientas como n8n y Page Assist.

En un mundo donde la inteligencia artificial (IA) está cada vez más integrada en nuestra vida diaria, la mayoría de las soluciones disponibles dependen de la nube. Sin embargo, para aquellos que buscan mayor seguridad y control sobre sus datos, ejecutar modelos de IA de manera local es una alternativa interesante. En este artículo hablaré de 2 opciones básicas para usar Ollama para implementar IA en tu propio equipo, destacando sus ventajas en seguridad, sus aplicaciones prácticas y cómo podemos crear una base de conocimiento personalizada.

¿Qué es Ollama?

Ollama es una plataforma que permite ejecutar modelos de IA localmente sin depender de servidores en la nube. Esto significa que puedes procesar información directamente en tu dispositivo, lo que garantiza mayor privacidad y control sobre los datos. Es una solución ideal para quienes trabajan con información sensible o simplemente desean evitar compartir datos con terceros. Es una herramienta Open Source y los modelos que puedes utilizar son aquellos que están disponibles bajo ese esquema.

Algunos de los modelos que puedes ejecutar con Ollama incluyen:

- Mistral: Excelente para tareas de generación de texto con alto rendimiento en español y otros idiomas.

- LLaMA: Un modelo versátil de código abierto que permite realizar resúmenes, traducciones y asistencia conversacional.

- Deepseek: Diseñado para análisis de datos avanzados y tareas de comprensión profunda del lenguaje. (Tienen una versión especial llamada deepseek-coder que también puede generar código para diferentes lenguajes de programación).

- Phi: Especializado en modelos compactos y eficientes, ideal para dispositivos con recursos limitados.

Cada uno de estos modelos tiene ventajas específicas según el caso de uso, permitiéndote elegir la mejor opción para tus necesidades.

Ventajas de Usar IA Localmente

1. Seguridad y Privacidad

Al ejecutar la IA en tu propia máquina, reduces la exposición de tus datos en servidores de terceros. Esto es especialmente relevante para empresas o profesionales que manejan información confidencial. Además, esto permite trabajar completamente desconectado de Internet, asegurando que ninguna información sensible salga de tu entorno local y garantizando el acceso a herramientas de IA incluso en lugares sin conexión.

2. Independencia de Internet

No necesitas estar conectado para realizar tareas con IA, lo que permite utilizar estas herramientas incluso en entornos con conectividad limitada.

3. Reducción de Costos

Evitas suscripciones a servicios en la nube, lo que puede representar un ahorro significativo a largo plazo. Sin embargo, es importante considerar que ejecutar modelos localmente no será tan rápido como en la nube, ya que los servidores remotos están optimizados para este tipo de tareas. Aun así, para un uso moderado, el rendimiento será suficiente y ofrecerá mayor privacidad y control sobre los datos.

4. Velocidad y Optimización

Dependiendo de tu hardware, ejecutar modelos localmente puede ser más rápido que enviar solicitudes a un servidor remoto.

Casos de Uso Prácticos

Ejecutar IA localmente abre un abanico de posibilidades para mejorar la productividad y optimizar tareas cotidianas. Algunos usos prácticos incluyen:

1. Asistentes Virtuales Personalizados

Puedes entrenar modelos para que actúen como asistentes personales que respondan preguntas sobre tus documentos, archivos o bases de datos sin comprometer la privacidad.

2. Automatización de Procesos

Desde la generación de contenido hasta la transcripción y traducción automática, puedes optimizar diversas tareas diarias sin depender de servicios externos.

3. Análisis de Datos y Reportes

Los modelos de IA pueden ayudarte a analizar datos y extraer información clave en tiempo real, permitiendo tomar decisiones más informadas.

4. Mejoras en Seguridad Informática

Algunas implementaciones pueden detectar análisis de patrones sospechosos en redes o archivos, mejorando la ciberseguridad.

Creación de una Base de Conocimiento Propia

Uno de los mayores beneficios de ejecutar IA localmente es la posibilidad de construir un Knowledge Base propio. Esto se logra alimentando un modelo con información relevante, permitiéndole responder preguntas específicas sobre documentos internos, archivos y datos empresariales. Los modelos de IA son entrenados para entender ámbitos específicos, lo básico es que pueden entender la forma en la que nos expresamos, hacer inferencia, resumir contenido y generar resultados en base a ese conocimiento, pero es siempre “genérico”, sin embargo, si los alimentamos con nuestros documentos, creamos nuestra base de conocimentos propia, donde hasta podríamos enseñarle a expresarse como nosotros lo haríamos normalmente, o poder dar respuesta a preguntas que nosotros sabemos por nuestro trabajo, nuestra empresa o inclusive el lugar donde crecimos.

Esta es una de las grandes ventajas, se convierte en tu “experto” personalizado. Otra ventaja es que los modelos sólo conocen la información que recibieron cuando fueron entrenados, con esto se los puede actualizar y agregar información más actualizada.

Pasos para Crear tu Base de Conocimiento con Ollama

- Instalar Ollama

- Descarga e instala Ollama según el sistema operativo de tu computadora.

- Asegúrate de contar con suficiente espacio en disco y una GPU si deseas aceleración por hardware.

- Seleccionar y Entrenar un Modelo

- Usa modelos preentrenados o ajusta uno según tus necesidades. Ollama tiene una librería extensa de modelos disponibles.

- La mayor limitación que tendrás dependerá de la cantidad de memoria de tu computador, más el procesador, aunque si tienes una tarjeta gráfica con un GPU suficientemente potente (pensemos en Gaming PCs) podrías lograr ejecutar modelos más complejos, pero en general para manipulación de texto, modelos como Llama, Phi o Mistral son más que suficientes.

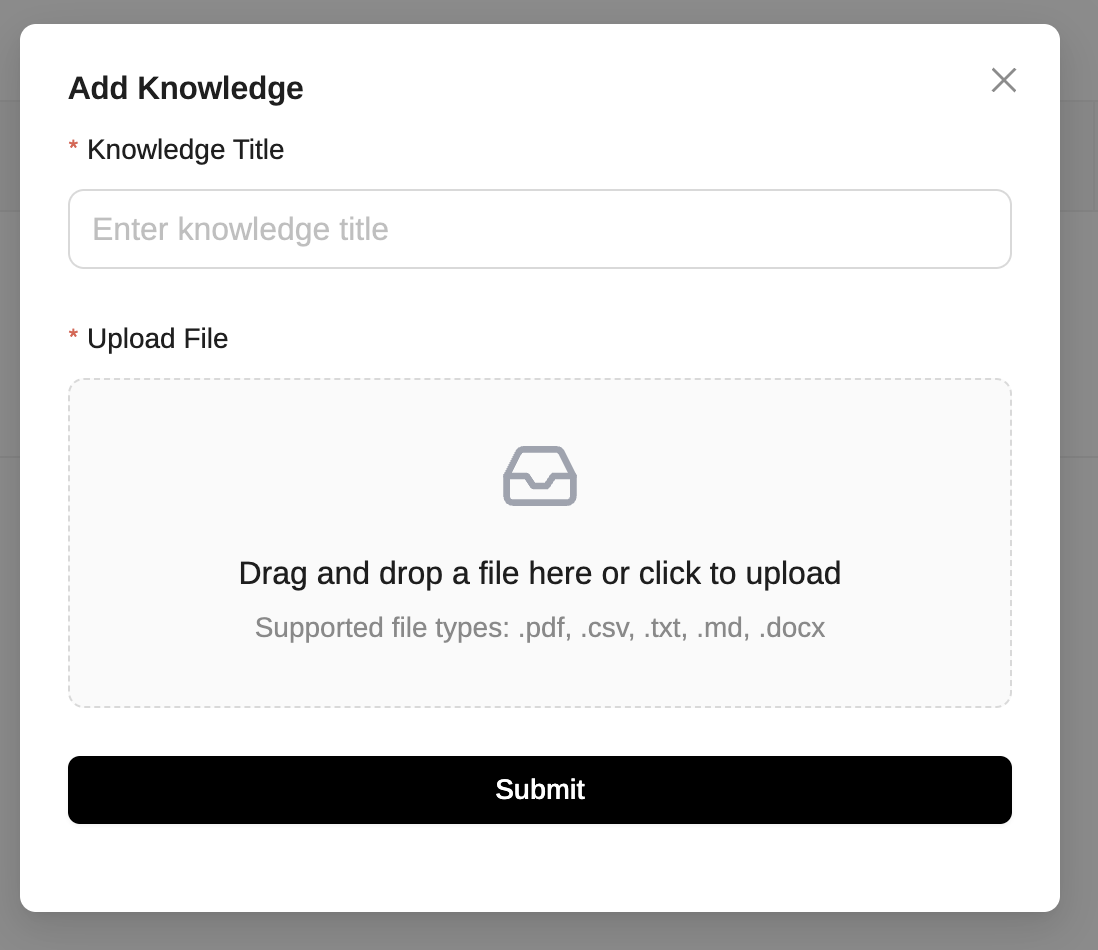

- Alimenta el modelo con documentos clave en formatos como PDF, TXT o JSON para que pueda responder de manera precisa. Puedes usar herramientas de procesamiento de texto para extraer información relevante y estructurarla en una base de datos local que el modelo pueda consultar.(Es mucho más fácil con las 2 herramientas que voy a explicar más adelante).

- Integrarlo con Herramientas Locales

- Puedes conectarlo con herramientas como notas, bases de datos o gestores de documentos. Por ejemplo, puedes usar n8n para automatizar la actualización de tu base de conocimiento al extraer información de correos, archivos o APIs y alimentarla a Ollama de forma estructurada. También, puedes integrar Ollama con plugins de Chrome para que procese y resuma información de páginas web directamente desde el navegador.

- Ollama al instalarse funciona desde la consola o a través de APIs que no es lo que la mayor parte de las personas van a querer, para saber cómo aprovecharlo sin complicaciones, sigue leyendo ;)

- Optimizar y Mejorar el Modelo

- Ajusta la base de datos de entrenamiento conforme a las respuestas que vayas obteniendo.

Acceso Remoto a tu Servidor Local

Si deseas acceder a Ollama desde otros dispositivos o entornos, puedes utilizar herramientas como Msty.app y Page Assist.

- Msty.app: Te permite acceder a tu servidor local de forma simple, es una aplicación disponible para Windows, Linux y Mac que se puede conectar ya sea con los modelos disponibles en internet (ChatGPT, Grok, etc), o directamente con Ollama, una vez que lo instalas lo detecta directamente y te entrega una interfaz muy parecida a la de ChatGPT.

- Page Assist: Un plugin de Chrome que te permite usar ollama desde el navegador para hacer preguntas como si fuera ChatGPT, pero tiene también una ventaja importante, puedes abrir PDFs o navegar a cualquier página web y usar el contenido de ese documento como “contexto” para pasárselo a la IA para que responda tus preguntas en base a lo que estás leyendo, o inclusive que te lo traduzca si fuera el caso.

Estas herramientas amplían la utilidad de Ollama, algo que ambas permiten es agregar documentos que puedan ser utilizados como base de conocimiento para realizar preguntas, pueden ser desde PDFs hasta apuntes propios que permitan definir las guías que le servirán para responder y se los pueden ser utilizados con los diferentes modelos.

Conclusión

El uso de IA localmente con Ollama no solo brinda una alternativa más segura y eficiente, sino que también permite personalizar la tecnología a nuestras necesidades específicas. En un mundo donde la privacidad y el control de la información son cada vez más relevantes, esta solución representa una opción atractiva para individuos y empresas que buscan aprovechar el poder de la IA sin comprometer su seguridad.

Si quieres empezar a experimentar con IA localmente, Ollama es un excelente punto de partida. ¡Explora sus posibilidades y descubre cómo la IA puede trabajar para ti!